相关内容

Powered by 浏览器之家 2025 © 浏览器之家 Inc.

Brave将本地 AI 引入浏览器

Brave 浏览器是基于 Chromium 的最好的免费开源网络浏览器之一。

当然,它有自己的特点,在集成加密技术方面也有一些争议。但它仍然可以说是速度最快、最注重隐私的浏览器之一。

为了解决正确问题,它尝试以一种有趣的方式将人工智能集成到其浏览器中。

今年早些时候,Brave 开始在其夜间(或开发)版本中为 Brave Leo 的 AI 功能试验“自带模型 (BYOM) ”。这个想法旨在让用户能够运行自定义 AI 模型或本地 AI 模型,以安全地使用 Brave Leo。

有了此功能,您不必信任 Brave 的集成 AI 模型或任何远程连接。您只需使用Ollama滑入您最喜欢的本地模型,并将对话保留在您的设备上

现在,此功能终于可以在 Brave 1.69 或更高版本上使用。我的同事在 1.70 上发现了这一点,我认为值得指出

使用自定义的本地或远程 AI 模型

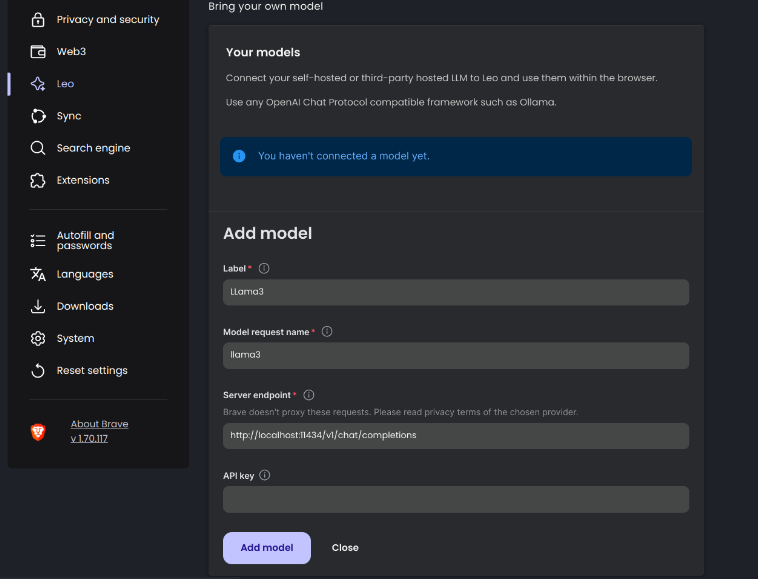

在 Brave 浏览器上查看 Brave Leo 设置的屏幕截图,用于添加本地 llama3 模型

我使用本地 AI 模型(即llama3 )测试了 Brave 的 BYOM 功能。你可以利用Ollama在 Linux 或其他平台上下载该模型。

完成后,前往Brave 的 Leo 设置,使用以下信息添加模型:

标签:您认为合适的任何自定义显示名称

模型请求名称:在此处输入模型名称

服务器端点:为 AI 模型提供的端点 URL。在我们的例子中,它是http://localhost:11434/v1/chat/completions(对于通过 Ollama 的本地模型)。

API 密钥:如果您使用的是远程 AI 模型,例如 OpenAI 的 ChatGPT 或其他模型。对于本地 AI 模型,您不需要它。

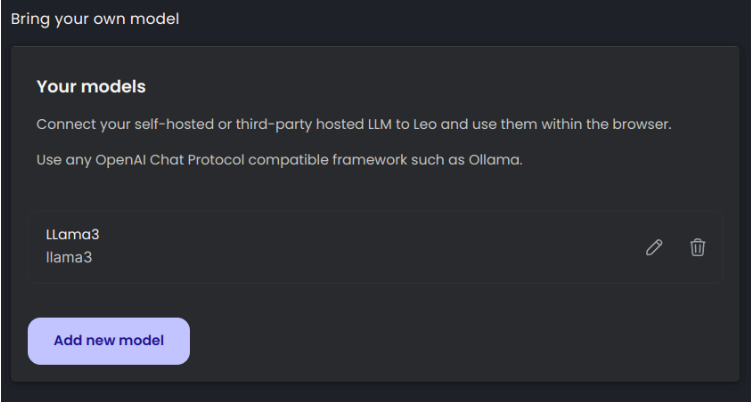

添加后,您就会看到它列为:

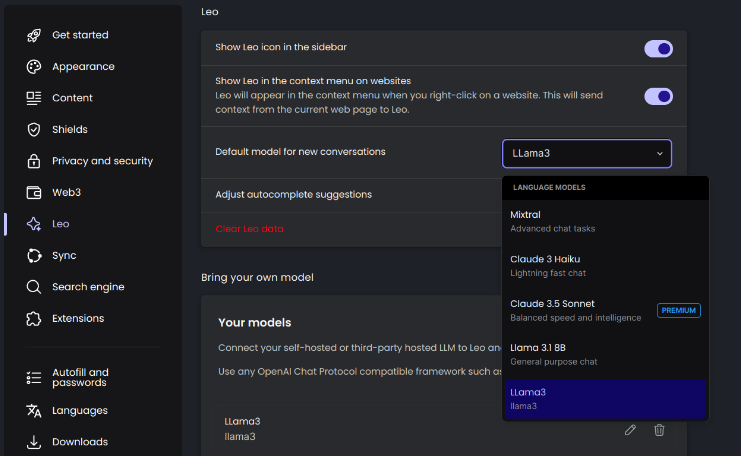

接下来,您需要在相同的设置中将其设置为“新对话的默认模型”,然后重新启动浏览器以便 Brave Leo 使用它。下面的屏幕截图应该会指导您如何执行此操作:

或者,您可以在使用 Brave Leo 时选择自定义 AI 模型

总结

Brave 的 BYOM 功能最令人兴奋的一点是,您不再需要单独的Web UI 来运行 LLM。当然,如果您想尝试在其他浏览器上使用本地 AI 模型, Page Assist是我的最爱之一。但是,如果您使用 Brave,您就不再需要它了。

我认为,有了这项功能,Brave 可以让你很好地控制你想使用什么 AI 模型(如何使用)以及何时不使用。这比任何 Web 浏览器强制集成以使用 AI 辅助要好。

上一篇:适用于Mac的热门浏览器推荐